復(fù)古大型舞臺設(shè)計(jì) 高清背景板地臺燈光素材與藝術(shù)大賽展廳大全

在當(dāng)今舞臺藝術(shù)與展廳設(shè)計(jì)中,復(fù)古風(fēng)格的大型舞臺背景板、地臺和燈光元素正成為一種流行趨勢。這些設(shè)計(jì)不僅喚起了觀眾對過去時(shí)代的懷舊情感,還融合了現(xiàn)代技術(shù),創(chuàng)造出獨(dú)特的視覺體驗(yàn)。本文為您介紹高清復(fù)古舞臺設(shè)計(jì)圖片素材的下載資源、模板應(yīng)用以及相關(guān)藝術(shù)大賽的展廳大全,幫助您快速獲取靈感與實(shí)用工具。

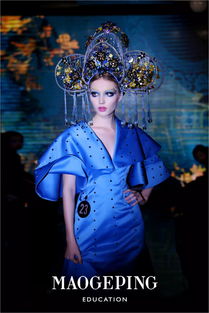

復(fù)古大型舞臺設(shè)計(jì)通常強(qiáng)調(diào)歷史元素的再現(xiàn),如維多利亞時(shí)代的華麗裝飾、工業(yè)革命的金屬質(zhì)感或20世紀(jì)中葉的簡約線條。背景板設(shè)計(jì)可能采用仿古紋理、褪色色調(diào)和經(jīng)典圖案,而地臺則通過層次結(jié)構(gòu)模擬舊式劇院的臺階或平臺。燈光設(shè)計(jì)在此扮演關(guān)鍵角色,利用暖色調(diào)和柔光效果營造出溫馨而神秘的氛圍,增強(qiáng)整體復(fù)古感。

針對素材資源,我們推薦一款高清模板下載,文件大小為2.42MB。該模板包含多種復(fù)古舞臺背景板、地臺和燈光的圖片素材,適用于各種設(shè)計(jì)軟件如Photoshop或Illustrator。用戶可以直接下載并自定義,節(jié)省設(shè)計(jì)時(shí)間。這些素材經(jīng)過優(yōu)化,確保在高分辨率下保持清晰,適合用于舞臺布景、藝術(shù)展覽或虛擬展廳項(xiàng)目。下載鏈接通常通過專業(yè)設(shè)計(jì)平臺提供,確保安全可靠。

展廳大全部分匯總了全球知名的藝術(shù)大賽和展覽空間,這些場所常采用復(fù)古舞臺設(shè)計(jì)元素。例如,國際舞臺藝術(shù)節(jié)或復(fù)古主題藝術(shù)展的展廳,展示了如何將背景板、地臺和燈光結(jié)合,營造沉浸式體驗(yàn)。通過參考這些案例,設(shè)計(jì)師可以學(xué)習(xí)如何平衡復(fù)古美學(xué)與現(xiàn)代功能性,提升作品的吸引力。

復(fù)古大型舞臺設(shè)計(jì)是一個(gè)多領(lǐng)域融合的藝術(shù)形式,通過高清素材和模板下載,結(jié)合展廳大全的啟發(fā),您可以輕松打造出令人難忘的視覺效果。無論是參與藝術(shù)大賽還是日常設(shè)計(jì)項(xiàng)目,這些資源都將提供寶貴的支持。立即下載并探索,開啟您的復(fù)古藝術(shù)之旅吧!

如若轉(zhuǎn)載,請注明出處:http://www.uhhj.cn/product/26.html

更新時(shí)間:2026-02-22 20:34:18